<aside> 💡 원저자(Maarten Grootendorst)의 허락을 받아 원문을 번역 및 검수중입니다.

</aside>

<aside> 🚧 번역 오류 발견시 알려주시면 수정하겠습니다.

</aside>

원문 저자: Maarten Grootendorst

번역: 신종훈

원문을 번역하고 일부 링크를 추가하였습니다. 해당 글의 1인칭은 원문 저자를 지칭합니다.

원문(Original English Post by Maarten Grootendorst):

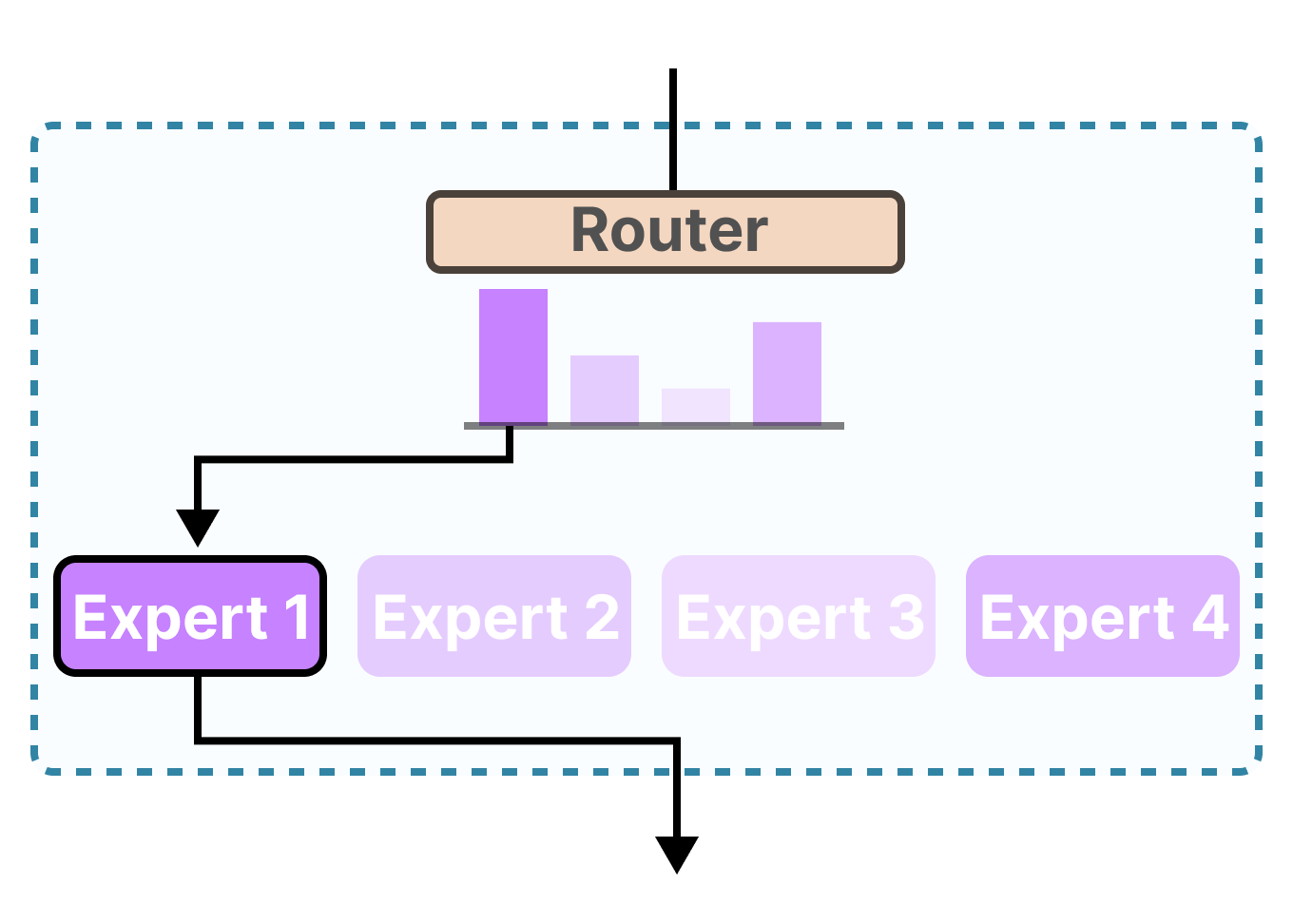

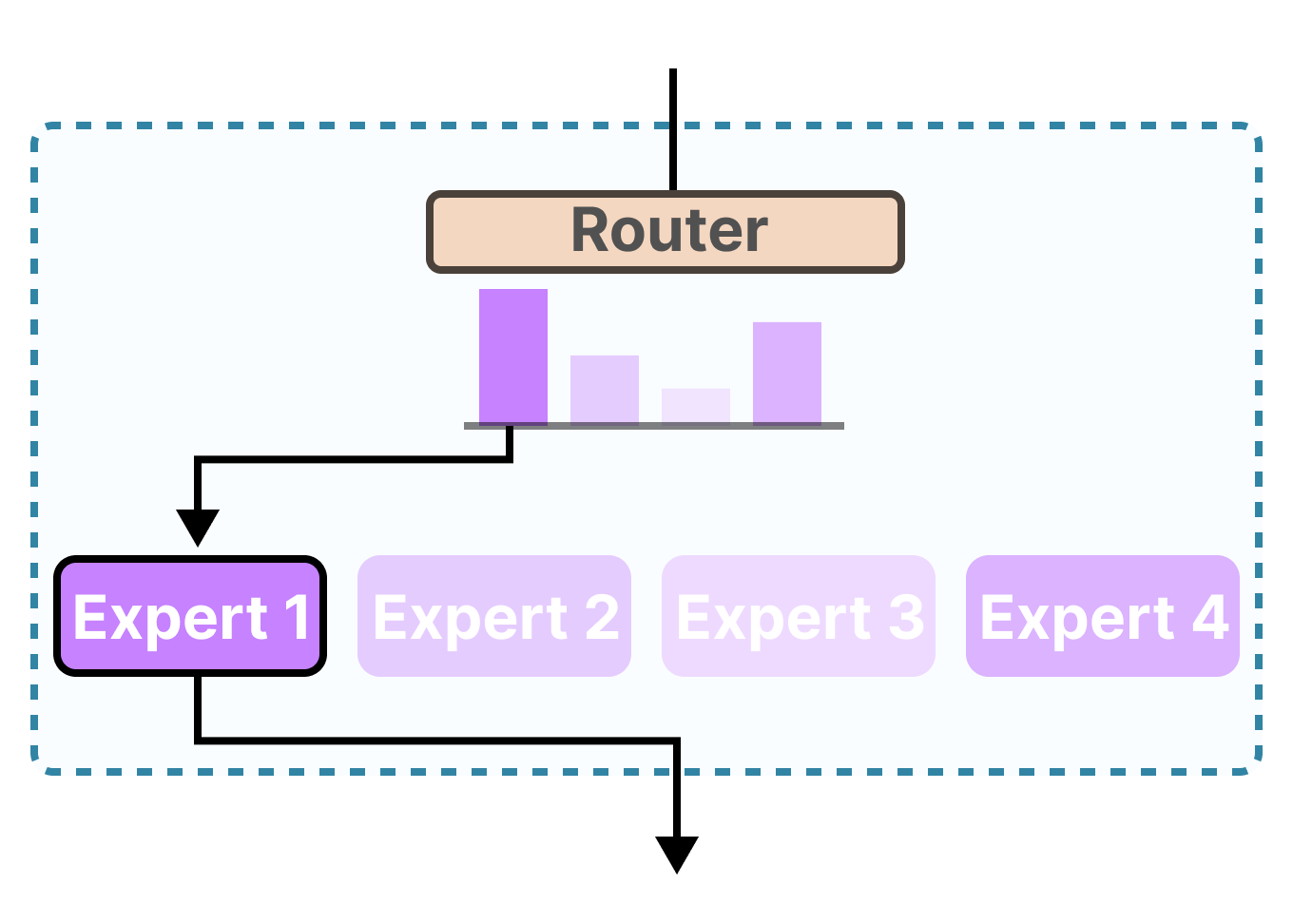

A Visual Guide to Mixture of Experts (MoE)

최신 Large Language Models (LLMs) 모델의 이름을 보면 종종 제목에 “MoE”라는 용어를 볼 수 있습니다. 이 “MoE”는 무엇을 의미하며 왜 많은 LLM들이 이를 사용하고 있을까요?

이 비주얼 가이드에서는 50개 이상의 시각화 자료를 통해 *Mixture of Experts (MoE)*이라는 중요한 구성 요소를 알아볼 것입니다!

이 비주얼 가이드에서는 일반적인 LLM 기반 아키텍처에 적용된 MoE의 두 가지 주요 구성 요소인 Expert와 Router에 대해 살펴보겠습니다.

이 비주얼 가이드의 여러 시각화 자료를 통해 Mixture of Experts에 관해 직관적으로 알 수 있을 것입니다.